iOS:制作简易的 AAC 播放器 —— 了解音频的播放流程

常用的播放文件,如 mp3、aac 都是已经封装的音频格式,将它们的文件提供到系统音频库或者第三方音频库,如 AVPlayer、IJKPlayer 等这些框架和播放器,然后声音就会由扬声器或耳机播放出来。如果读者对这些神奇的过程有兴趣,那就进入本次的了解旅程。

《iOS 视音频入门系列》

- [iOS 隐形水印之 LSB 实现]

- [图像の二值图]

之前的都是针对图像,而本次来聊聊音频。

前言

本次将基于 iOS 实现对aac(ADTS)文件的播放来讲解音频的播放流程。它将包括如下内容,可能大伙对这些名称有所耳闻:解封装、解编码等。流媒体的播放其实就是基于这些步骤来实现的。

_______ ______________ ________

| | | | | |

| aac | demuxer | audio | decoder | audio |

| file | ---------> | encoded data | ---------> | raw |

|_______| |______________| |________|AAC

aac 的应用很广泛,在直播 rtmp 和 http-flv 中也使用的此音频格式。

❝AAC,全称Advanced Audio Coding,是一种专为声音数据设计的文件压缩格式。与MP3不同,它采用了全新的算法进行编码,更加高效,具有更高的“性价比”。利用AAC格式,可使人感觉声音质量没有明显降低的前提下,更加小巧。

Demo 使用的 aac 音频信息如下:

Input #0, aac, from 'video.aac':

Duration: 00:00:30.45, bitrate: 133 kb/s

Stream #0:0: Audio: aac (LC), 44100 Hz, stereo, fltp, 133 kb/s解封装

解封装的最重要的目的是将 音频 的 音频的信息 & 音频的编码数据 分离出来。

而 aac 是由多个 header + es body 组成。header 固定 7 个字节,所以只需每次读取 7 个字节,然后再读出 size,就能得到得到对应块的数据,从而得到 raw 数据。

// 读取 header

int head_buf_size = 7;

int *head_buf = malloc(head_buf_size);

fread(head_buf, 1, head_buf_size, _in_file);

// 读取 size

int s1 = ((int)(*(((uint8_t *)head_buf) + 3))&0x3) << 11;

int s2 = ((int)(*(((uint8_t *)head_buf) + 4))) << 3;

int s3 = (int)(*(((uint8_t *)head_buf) + 5)) >> 5;

int size = s1 + s2 + s3;

// 读取 raw

int raw_buf_size = size - head_buf_size;

int *raw_buf = malloc(raw_buf_size);

fread(raw_buf, 1, raw_buf_size, _in_file);header 还包含其他音频信息,它们是解码时需要的,如采样率、声道数等

int head_buf_size = 7;

int *head_buf = malloc(head_buf_size);

fread(head_buf, 1, head_buf_size, file);

// 采样率标识

int freqIdx = ((int)(*(((uint8_t *)head_buf) + 2))&0x3C) >> 2;

// 声道数

int c1 = ((int)(*(((uint8_t *)head_buf) + 2))&0x1) << 2;

int c2 = ((int)(*(((uint8_t *)head_buf) + 3))&0xC0) >> 6;

int chanCfg = c1 + c2;

// 返回

complete(freqIdx == 3 ? 48000 : 44100, chanCfg);上面的格式是 aac 的格式协议制定的,只要按照要求读取即可,就是哪几个字节,哪几个bit 对应的哪些内容,它的值表示什么都是约定的。

Demo 只读出了 aac 的 raw、sample_rate、channels。

解码

解码的是使用 AudioConverterRef,可能有人问这里的细节,但这里不会展开,因为有点超纲,大伙可以搜搜 AAC解码原理 之类的标题(PS:别问,问就是不废)。

而使用 AudioConverterRef 就可以轻松的完成解码,只需配置输入&输出的 AudioStreamBasicDescription,然后将读取的 raw 写入即可得到解码后的数据。

// 输入

- (AudioStreamBasicDescription)createAACAduioDes {

UInt32 channels = _channels;

AudioStreamBasicDescription audioDes ={0};

audioDes.mSampleRate = _sampleRate;

audioDes.mFormatID = kAudioFormatMPEG4AAC;

audioDes.mFormatFlags = kMPEG4Object_AAC_LC;

audioDes.mBytesPerPacket = 0;

audioDes.mFramesPerPacket = 1024;

audioDes.mBytesPerFrame = 0;

audioDes.mChannelsPerFrame = channels;

audioDes.mBitsPerChannel = 0;

audioDes.mReserved = 0;

return audioDes;

}

// 输出

- (AudioStreamBasicDescription)createPCMAduioDes {

UInt32 bytesPerSample = sizeof(SInt32);

UInt32 channels = _channels;

AudioStreamBasicDescription audioDes ={0};

audioDes.mSampleRate = _sampleRate;

audioDes.mFormatID = kAudioFormatLinearPCM;

audioDes.mFormatFlags = kLinearPCMFormatFlagIsNonInterleaved | kAudioFormatFlagIsFloat | kAudioFormatFlagIsPacked;

audioDes.mBytesPerPacket = bytesPerSample;

audioDes.mFramesPerPacket = 1;

audioDes.mBytesPerFrame = bytesPerSample;

audioDes.mChannelsPerFrame = channels;

audioDes.mBitsPerChannel = 8 * bytesPerSample;

audioDes.mReserved = 0;

return audioDes;

}// decode

AudioConverterFillComplexBuffer(self->_audioConverter,

inputDataProc,/*输入数据的函数*/

(__bridge void * _Nullable)(self),

&ioOutputDataPacketSize,

outAudioBufferList,/*构造返回的数据*/

NULL);以上代码的过程就是将上一步解封装后的 data 转成 AudioBufferList,再通过 AudioConverter 解码,从输出的 AudioBufferList 获取 pcm 数据。

播放

播放使用AudioUnit & AUGraph,这是 iOS 底层的音频框架,通过它还可以进行很多有趣的自定义,如变音。对于 AudioUnit 的学习内容就很多,可以自行搜索学习即可。此处播放,只需按 Demo 操作固定步骤即可。

OSStatus status;

status = NewAUGraph(&_auGraph);

[self addAUNode];

status = AUGraphOpen(_auGraph);

[self getAUsFromNodes];

[self setAUProperties];

[self makeAUConnects];

CAShow(_auGraph);

status = AUGraphInitialize(_auGraph);到这一步,只要把 encode raw 给到 AudioUnit 就可以播放。此音频播放器属于消费者模式,它是反向跟前面要数据来播放,如下:

___________ ______________

| | 1.playback | |

| demuxer | <--------- | AudioUnit |

| decoder | ---------> | |

|___________| 2.pcm |______________| - AudioUnit 向 decoder 要 pcm 数据

- decoder 将解码数据给过去,数据够直接提供,数据不够向 demuxer 要

- demuxer 去解封装更多源数据,返回给 decoder 解码

// 数据不够

if (self.data.length < size) {

// 解封装

NSData *d = [_reader read_aac_raw_buf];

if (d == nil) {

return nil;

}

// 解码

AudioBufferList *b = [_decoder decodeAudioSamepleBuffer:d];

// 保存

[self.data appendBytes:b->mBuffers[0].mData length:b->mBuffers[0].mDataByteSize];

}

// 返回 AudioUint 需要的数据

NSData *b = [self.data subdataWithRange:NSMakeRange(0, size)];这样处理可以避免一次性将 aac 解码,封装的目的就是降低文件大小,方便传输和保存。如果全部解码出来,对于高音质的音频文件就会生成很大的文件,占用大量的内存,并且播放时,快进或者直接结束,没有播放的部分即浪费空间又浪费算力。因此需要播放的部分才去解封装 & 解码更好。

❝这里的 video.aac 文件大概是 500kb,解码后的 pcm 是 5.5M

播放器 Demo

- QHAudioConverterMan: acc 播放器 https://gitee.com/chenqihui/qhaudio-converter-man

Demo 代码只供参考,暂没优化。

转码

由于近期直播需要字幕识别,而语音的识别对音频格式有要求限制,搜狗和讯飞的格式是一样的。以讯飞官方要求为例:> ❝讯飞语音能力一般情况下支持如下音频格式:

pcm(pcm_s16le),wav,speex(speex-wb) 采样率为16000 或者 8000. 推荐使用16000,比特率为16bit 单声道

而这里可以使用 <span style="font-size: 16px;">AudioConverterRef 进行转码,让 pcm 符合要求

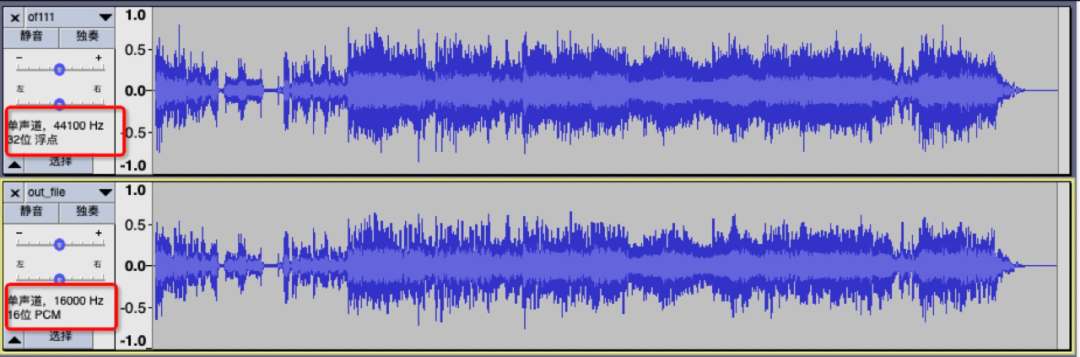

下面是 44100_32f_1 to 16000_16f_1 的波形图:

虽然波形图看着差不多,但其实还是有很大的不同。导致转码失真,应该是某些参数设置有误差或者本人写的读取测试代码有误。由于这里只是顺便写的转码代码,暂时忽略它。

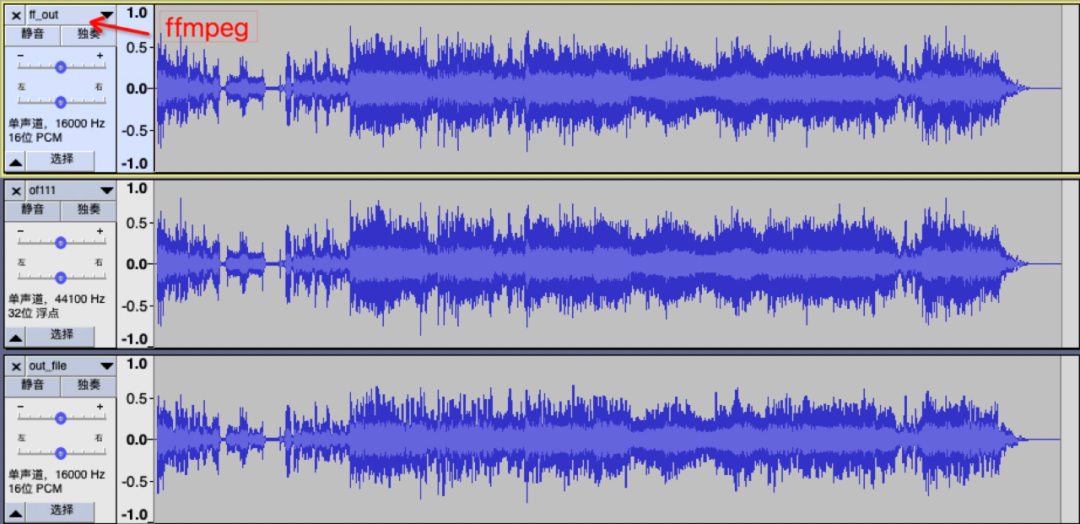

而使用 ffmpeg 命令的转码,如下:

效果相当地好啊,肉眼可见的,不过也有小小的失真,你们切换频谱图看看就知道哈,这里就不展示了。

ffmpeg -ac 1 -ar 44100 -f f32le -i of111.pcm -ac 1 -ar 16000 -f s16le ff_out.pcm

参考

-

音频属性相关:声道、采样率、采样位数、样本格式、比特率https://www.cnblogs.com/yongdaimi/p/10722355.html#_label5

-

AAC ADTS格式分析

https://zhuanlan.zhihu.com/p/162998699

-

AAC ADTS格式分析https://blog.csdn.net/tantion/article/details/82743942