新增消费组出现异常排查流程

- 操作说明

- 异常日志

- 问题分析过程

- 解决方案

操作说明

启动一个消费组的时候,出现了异常

异常日志

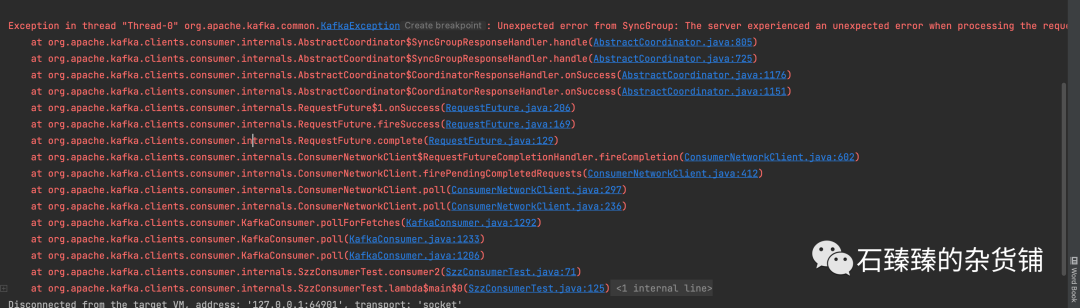

异常日志:

Unexpected error from SyncGroup: The server experienced an unexpected error when processing the request.

问题分析过程

这个问题,首先看日志,我们知道是发生在 SyncGroup请求的时候, 也就是一个新的消费者加入消费组并同步的时候抛出了异常;

看这个异常字母意思: 发生了不可预期的错误。

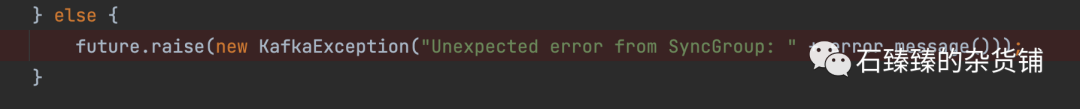

我们看看这个异常的具体位置在 SyncGroupResponseHandler#handle

所以我们要看看 SyncGroupRequest请求中抛出的异常:The server experienced an unexpected error when processing the request. 在哪里;

既然这个异常是上层抛出来的, 那么就应该去Kafka集群中查看一下有没有相关的异常抛出。

经过查询Kafka日志,发现几个异常:

[2022-10-19 15:14:01,224] ERROR [GroupMetadataManager brokerId=1] Appending metadata message for group group_consumer_4 generation 6 failed due to org.apache.kafka.common.errors.RecordTooLargeException, returning UNKNOWN error code to the client (kafka.coordinator.group.GroupMetadataManager)

[2022-10-19 15:14:01,224] ERROR [GroupMetadataManager brokerId=1] Appending metadata message for group group_consumer_4 generation 6 failed due to org.apache.kafka.common.errors.RecordTooLargeException, returning UNKNOWN error code to the client (kafka.coordinator.group.GroupMetadataManager)

[2022-10-19 15:14:01,224] WARN [GroupCoordinator 1]: Failed to write empty metadata for group group_consumer_4: The server experienced an unexpected error when processing the request. (kafka.coordinator.group.GroupCoordinator)

[2022-10-19 15:14:01,224] WARN [GroupCoordinator 1]: Failed to write empty metadata for group group_consumer_4: The server experienced an unexpected error when processing the request. (kafka.coordinator.group.GroupCoordinator)

分析上面日志我们可以知道, 在SyncGroup请求的时候,需要把GroupMetadata元信息写入到 __consumer_offset中。

但是因为在写入的过程中,发现写入的消息量太大了,导致抛出了异常:RecordTooLargeException

那么,接下来排查一下自己的 最大消息体量配置了多大:message.max.bytes

这里我之前测试的时候 手动把它设置为了 20, 那肯定远远小于了一个普通消息体量

解决方案

message.max.bytes 设置大一点。

本文只是提供一种排查思路, 如果有其他类型的异常,也是抛出了这个异常,那么排查方向是差不多的。

各位小伙伴有什么看法,欢迎评论区留言探讨~